Los 5 mejores raspadores web para recuperar datos en línea

Las herramientas de Web Scraping están diseñadas específicamente para extraer información de sitios web. También se conocen como herramientas de recopilación web o herramientas de recuperación de datos web.Estas herramientas son útiles para todos. Intentar recopilar algún tipo de datos. de la web. Web scraping es Nueva tecnología de entrada de datos. No es necesario ingresar repetidamente o copiar y pegar.

estos programas Encuentra nuevos datos de forma manual o automática, recupera datos nuevos o actualizados y los almacena para facilitar el acceso. Por ejemplo, se pueden usar robots para recopilar información sobre productos y sus precios de Amazon.

En esta publicación enumeramos los casos de uso de web scrapers y los 5 mejores web scrapers para recopilar información, cero codificación.

39 servicios web gratuitos y herramientas para monitorear el tiempo de inactividad del sitio web

Su portal de negocios en línea genera tráfico y lo último que queremos es un sitio web... Lee mas

¿Por qué usar un web scraper?

Las herramientas de raspado de red se pueden usar para infinitos propósitos en una variedad de escenarios, pero cubriremos algunos usos comunes que se aplican a los usuarios comunes.

Recoger datos para estudios de mercado.

El raspador web puede ayudarlo a determinar a dónde irá su empresa o industria en los próximos seis meses como una poderosa herramienta de investigación de mercado. Estas herramientas toman datos de múltiples proveedores de análisis de datos y firmas de investigación de mercado y los consolidan en un solo lugar para una fácil referencia y análisis.

Recuperar información de contacto

Estas herramientas también se pueden utilizar para recuperar datos como correos electrónicos y números de teléfono de varios sitios web para obtener una lista de proveedores, fabricantes y otras personas interesadas en su negocio o empresa, junto con sus respectivas direcciones de contacto.

Descarga la solución desde StackOverflow

Con la ayuda de un raspador web, también es posible descargar soluciones para lectura o almacenamiento fuera de línea mediante la recopilación de datos de múltiples sitios, incluidos StackOverflow y otros sitios de preguntas y respuestas. Esto reduce la dependencia de una conexión a Internet activa, ya que los recursos son fácilmente accesibles a pesar del acceso a Internet.

en busca de un trabajo o un candidato

Para aquellos que están buscando activamente más candidatos para unirse a su equipo, o para los buscadores de empleo que buscan roles o trabajos específicos, estas herramientas también son excelentes para recuperar datos fácilmente en función de varios filtros aplicados y recuperar datos de manera eficiente sin necesidad de búsqueda manual. .

Seguimiento de precios en múltiples mercados

Si le gusta comprar en línea y realizar un seguimiento activo de los precios de los productos que está buscando en muchos mercados y tiendas en línea, definitivamente necesita un web scraper.

Ejemplos de grandes web scrapers

Echemos un vistazo a algunas de las mejores herramientas de raspado disponibles en la web. Algunos de ellos son gratuitos y otros tienen un período de prueba y planes premium. Revise los detalles antes de suscribirse a alguien para sus necesidades.

1 robot de raspado

ScrapingBot es una excelente API de raspado web para desarrolladores web que necesitan extraer datos de las URL. Funciona especialmente bien en páginas de productos que recopilan todo lo que necesita (imágenes, títulos de productos, precios de productos, descripciones de productos, inventario, costos de envío, etc.). Esta es una gran herramienta para aquellos que necesitan recopilar datos comerciales o simplemente resumir datos de productos y mantenerlos precisos.

ScrapingBot también proporciona varias API especializadas, como inmobiliaria, resultados de búsqueda de Google o recopilación de datos en redes sociales (LinkedIn, TikTok, Instagram, Facebook, Twitter).

característica

- cromo sin cabeza

- Tiempo de reacción

- solicitudes simultáneas

- Permite la necesidad de raspado con un gran volumen.

Precio

- 100 puntos de uso gratuito al mes. Luego el primer paquete son 39 euros, 99 euros, 299 euros, luego 699 euros.

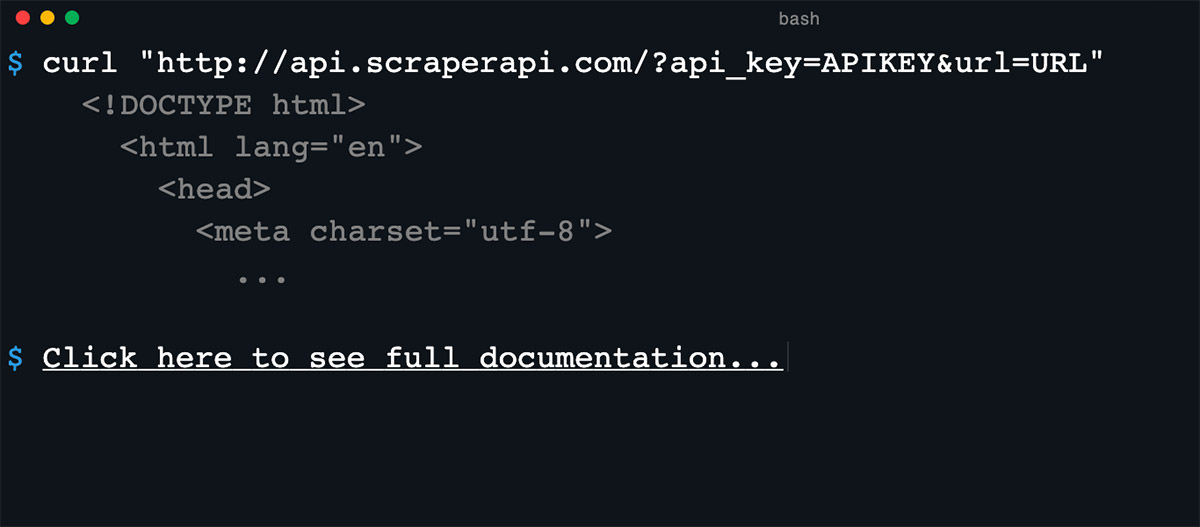

2. API de rastreador

La API Scraper está diseñada para simplificar el scraping en la web. Esta herramienta API de proxy puede administrar servidores proxy, navegadores web y captcha.

Admite lenguajes de programación populares como Bash, Node, Python, Ruby, Java y PHP. La API Scraper tiene muchas características; algunos básicos son:

Es totalmente adaptable (tipo de consulta, encabezados de consulta, navegador sin cabeza, geolocalización de IP).

- Rotación de IP.

- Más de 40 millones de direcciones IP.

- Capacidad para mostrar JavaScript.

- Ancho de banda ilimitado con velocidades de hasta 100Mb/s.

- más de 12 ubicaciones geográficas y

- Fácil de integrar.

La API Scraper ofrece 4 planes: Hobby ($ 29 / mes), Startup ($ 99 / mes), Business ($ 249 / mes) y Enterprise.

3. import.io

Import.io proporciona un constructor para crear sus propios conjuntos de datos simplemente importando datos de una página web específica y exportando los datos a CSV. Puede rastrear fácilmente miles de páginas web en minutos sin escribir código y Cree más de 1000 API según sus requisitos.

Import.io utiliza tecnología de punta para absorber millones de datos todos los días que las empresas pueden usar por una pequeña tarifa. Además de las herramientas de red, también proporciona un Aplicación gratuita para Windows, Mac OS X y Linux Cree herramientas de recuperación de datos y robots, descargue datos y sincronice con cuentas en línea.

4. Dexi.io (anteriormente CloudScrape)

CloudScrape admite la recopilación de datos de cualquier sitio web y, al igual que Webhose, no se requiere descarga. Proporciona un editor basado en navegador para la configuración de robots y la recuperación de datos en tiempo real. Guarde los datos recopilados en la plataforma en la nube Como Google Drive y Box.net o exportar a CSV o JSON.

CloudScrape también admite acceso anonimo a los datos Oculte su identidad proporcionando un conjunto de servidores proxy. CloudScrape almacena sus datos en sus servidores durante 2 semanas antes de realizar la copia de seguridad. El rastreador web ofrece 20 horas de rastreo gratis y cuesta $ 29 por mes.

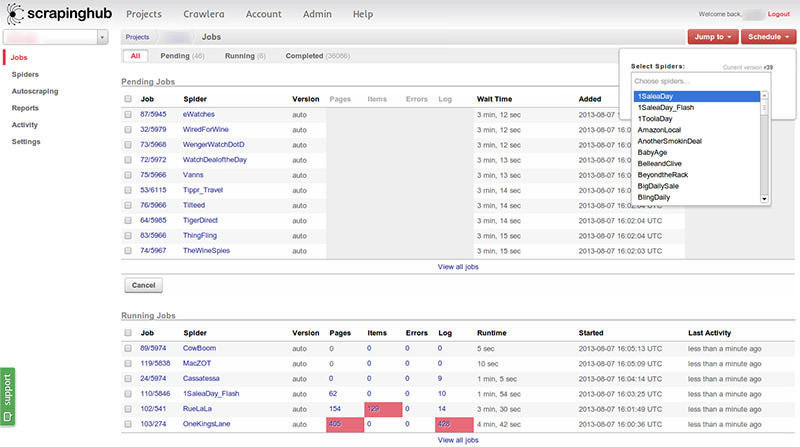

5. cansado

Zyte (anteriormente Scrapinghub) es una herramienta de minería de datos basada en la nube que ayuda a miles de desarrolladores a recuperar datos valiosos. Zyte usa Crawlera, un proxy spinner inteligente, Soporte para eludir las contramedidas de los bots Rastrea fácilmente sitios web grandes o protegidos contra bots.

Zyte lo hará Páginas web enteras en contenido organizadoSi su diseñador de orugas no cumple con sus requisitos, su equipo de expertos puede ayudarlo. Su plan gratuito básico te da acceso a 1 rastreo simultáneo, y su plan premium de $25 al mes te da acceso a hasta 4 rastreos simultáneos.

Bono: Y un poco más...

Centro de análisis

ParseHub se utiliza para raspar sitios web únicos y múltiples, admite JavaScript, AJAX, sesiones, cookies y redireccionamientos. La aplicación utiliza tecnología de aprendizaje automático. Identificar los archivos más complejos Genere archivos de salida en la red y de acuerdo con el formato de datos deseado.

ParseHub, además de la aplicación web, también está disponible como Aplicación de escritorio gratuita para Windows, Mac OS X y Linux Hay disponible un plan gratuito básico que cubre 5 proyectos de rastreo. El servicio ofrece un plan premium de $ 89 por mes, que admite 20 elementos y 10,000 páginas web para rastrear.

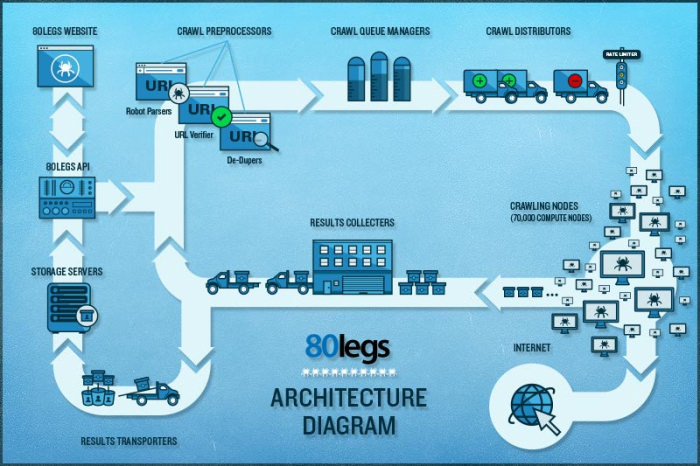

80 pies

80legs es un robot web potente y flexible que se puede configurar para satisfacer sus necesidades. Admite la opción de extraer grandes cantidades de datos, así como recuperar instantáneamente los datos extraídos. Afirma rastrear más de 600.000 dominios. Y es utilizado por grandes empresas como MailChimp y PayPal.

Estádatosfiniti'dejas Búsqueda rápida en toda la información.80legs proporciona un robot web de alto rendimiento que se ejecuta rápido y obtiene los datos que necesita en segundos. Ofrece un plan gratuito de URL de rastreo de 10K y se puede actualizar a un plan introductorio de $ 29 por mes para URL de rastreo de 100K.

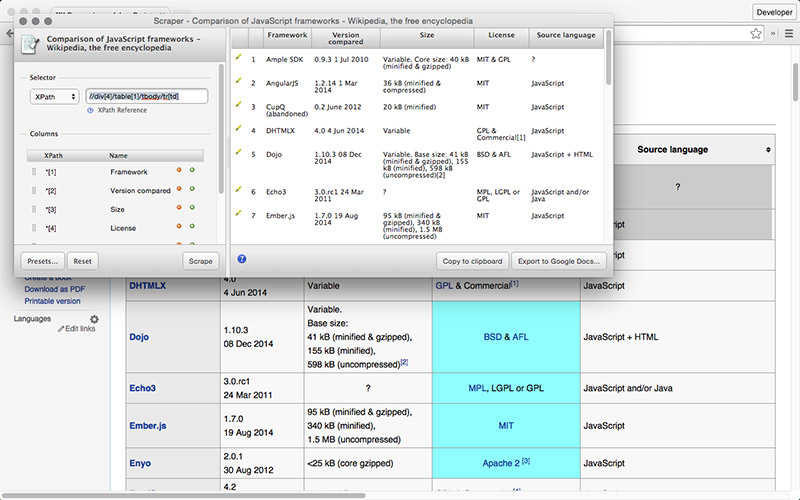

raspador

Scraper es una extensión de Chrome con capacidades limitadas de recuperación de datos, pero ayuda con la investigación en línea y Exportar datos a hojas de cálculo de GoogleEsta herramienta es para principiantes y expertos que pueden copiar fácilmente datos en el portapapeles o guardarlos en una hoja de cálculo usando OAuth.

Scraper es una herramienta gratuita que funciona bien en su navegador y genera automáticamente XPaths más pequeños para definir las URL de extracción. No hay necesidad de lidiar con una configuración desordenada.

¿Qué web scraper o complemento es tu favorito? ¿Qué datos quieres extraer de Internet? Comparta su historia con nosotros utilizando la sección de comentarios a continuación.

Deja una respuesta